近日,电子信息学院智能检测与边缘计算课题组在计算机领域国际知名期刊《Computer Networks》(CCF B类,JCR一区)发表最新研究成果“DGPAS: DQN-GRU guided distributed DNN pipeline training and adjacent scheduling in edge networks”。该成果以上海电机学院为第一单位,由电子信息学院在读硕士研究生李家仪为第一作者、硕士研究生导师王小刚教授为通讯作者,携课题组其他研究生与上海交通大学计算机学院以及澳大利亚墨尔本大学云与分布式系统实验室合作完成。

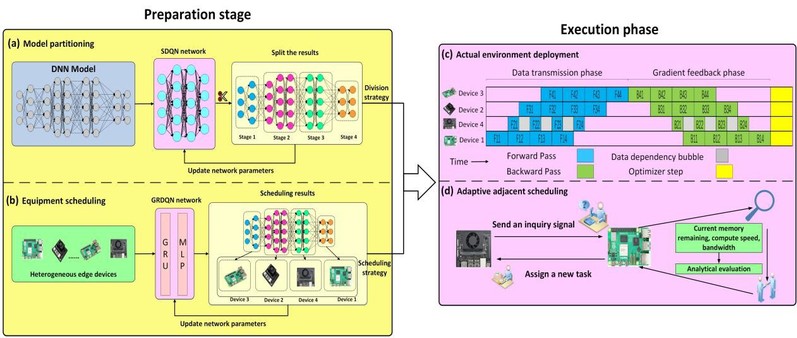

深度神经网络(Deep neural network, DNN)越来越多地被部署在分布式边缘计算环境中,以满足各种工业生产中的实时计算机视觉检测任务需求。然而,边缘端的DNN模型训练和推理往往面临计算资源竞争、传输带宽受限以及通信设备异构等情况的影响。现有方法未能有效解决异构边缘设备中任务调度不均衡和设备空闲等待等问题。为此,本研究提出了一种DQN-GRU引导的分布式深度神经网络流水线训练与相邻调度模型(DGPAS),显著提高了异构边缘网络中资源受限设备深度神经网络的训练效率。结合深度强化学习和时序特征建模,基于同步流水线并行机制,将模型框架分为准备阶段和执行阶段,分别进行DNN模型划分和设备调度。

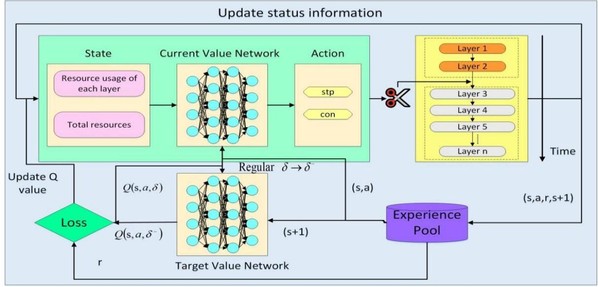

将深度Q网络(DQN)与门控循环单元(GRU)网络相结合,设计了SDQN和GRDQN这两个网络模型对决策过程进行优化,从而在模型阶段划分和设备调度中获得最优策略,进而有效提升了模型的训练效率。此外,在执行阶段设计了一种新的自适应相邻调度策略,即基于相邻设备的资源状态和计算能力动态调整任务分配(即通过时间同步和负载均衡优化来调整边缘设备间的计算负载),以解决由设备性能差异导致的“数据依赖气泡”问题,确保即使在复杂动态环境中也能保持较好的训练效率。

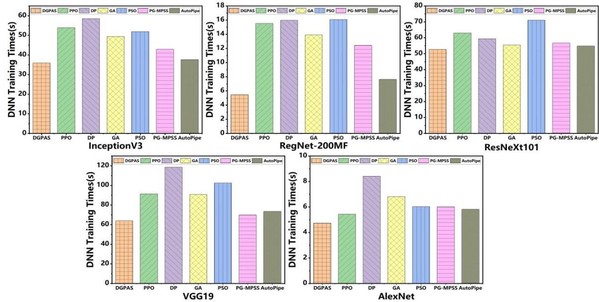

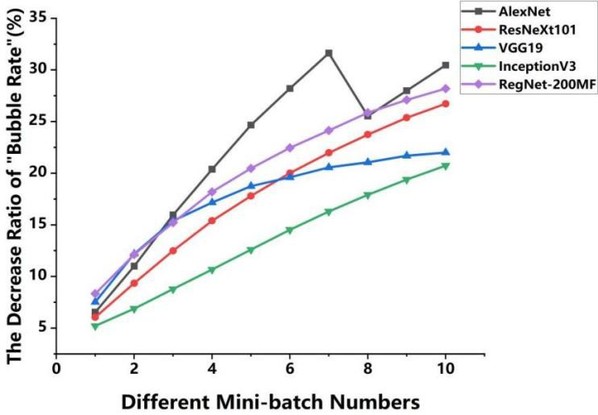

实验在配置有GPU和树莓派5的15块异构边缘推理板构成的分布式平台上进行。实验结果表明,在5类主流DNN模型下,与基线和现有相关方法相比,本研究提出的DGPAS将GRU与DQN相结合,平均训练时间减少了36.5%。采用自适应相邻调度方法后,在相同DNN模型和不同mini-batch数量下,训练过程中“气泡率”平均下降36.96%,显著提高了边缘DNN模型的训练效率和鲁棒性。(供稿:电子信息学院)

论文链接: https://doi.org/10.1016/j.comnet.2025.111592